L’essor des centres de données : intelligence artificielle, cyberespace, pouvoir et territoire

Bibliographie | mots-clés | citer cet article

En quelques décennies, l’humanité a connu une révolution numérique qui a profondément bouleversé les dynamiques sociales, culturelles, productives et territoriales. Les données numériques sont devenues une nouvelle « matière première » en plein essor, et pour certains une marchandise. Pour la stocker, la protéger et la traiter sont nés des entrepôts d’un type particulier : les centres de données, ou data centers en anglais. Apparue dans les années 2000 et démocratisée dans les années 2020, l’intelligence artificielle – une nouvelle innovation de rupture – a ensuite décuplé leur développement.

Insérées dans les réseaux de transport (câbles, routeurs...) et de gestion de l’internet, toutes ces infrastructures névralgiques finissent par faire système : c’est l’espace numérique, ou cyberespace, dans sa version matérielle : l’espace du fonctionnement d’internet. Loin d’être éthéré dans un nuage vaporeux (comme peut laisser croire l’image du cloud, « nuage »), une étude efficiente du cyberespace – c’est-à-dire de ses structures, de son fonctionnement, de ses dynamiques et de ses acteurs – impose de bien articuler espaces, réseaux, sociétés et territoires. En particulier, ces entrepôts de données sont au cœur de nombreux enjeux : rivalités de puissance, souveraineté, compétitivité, innovation, système énergétivore et environnement...

1. Les centres de données : des entrepôts spécialisés

Les centres de données et leurs corollaires (centres de diffusion des contenus, centres d’élimination des attaques) représentent la dimension matérielle, physique, de nos sociétés du numérique, fondées sur la massification de l’usage des données. Leur localisation est stratégique mais ils ne représentent pas une manne d’emploi pour les territoires où ils sont implantés.

1.1. Les si indispensables centres de données, ou « data centers »

On assiste ces dernières décennies à une explosion de la production de données numériques (textes, images, films, statistiques...). Le marché de la « big data » se compte en centaines de milliards de dollars et est piloté par de puissantes firmes transnationales, en particulier les GAFAM. Facebook détiendrait ainsi plus de 300 pétaoctets de données sur ses serveurs, soit l'équivalent de quelque 150 000 milliards de pages de texte imprimées au format A4. Multipliés par dix en dix ans, les volumes de données numériques représenteraient aujourd’hui 147 zettabytes, soit 147 milliards de gigabytes, et devraient encore augmenter de 40 % par an durant les prochaines années avec le développement de l’intelligence artificielle. Ce boom de la donnée entraîne mécaniquement un besoin accru de stockage et de traitement de celle-ci ; comme en témoignent les créations de firmes spécialisées comme Amazon Web Service – AWS en 2002, Microsoft Azur en 2010, IBM SmartCloud en 2011 ou Oracle Cloud en 2012. En dix ans, les ventes mondiales d’AWS sont multipliées par 13 pour dépasser les 100 milliards de dollars en 2024, et dans le même temps les surfaces de ses centres de données sont multipliées par 5.

Document 1. L’explosion du volume des données numériques

| Volume mondial de données numériques en zettabytes (milliards de gigabytes) | 2015;2016;2017;2018;2019;2020;2021;2022;2023;2024;2025 | |||

| 16;18;26;33;41;64;79;97;120;147;181 | #e31e51 |

Source : Global X.

Document 2. L’essor des ventes d’AWS, la filiale cloud/centres de données d’Amazon, numéro 1 mondial

| Ventes (millions de dollars) | 2015;2016;2017;2018;2019;2020;2021;2022;2023;2024 | |||

| 8;12;17;26;35;46;62;80;91;108 | #e31e51 |

Source : AWS.

Pour répondre à ces besoins, le nombre mondial de centres de données explose, passant de 8 000 à 10 000 entre 2023 et 2025 (+ 25 % en trois ans). En 2025, le marché des centres de données s’élève à 405 milliards de dollars, soit déjà 7 % des 5 610 milliards de dollars de dépenses informatiques mondiales (Gartner, 2025), et la demande mondiale devrait augmenter de + 20 % par an d'ici à 2030. La construction des centres de données mobilise ces six dernières années 1 300 milliards de dollars, soit l’équivalent du PIB 2023 d’un grand pays comme l’Indonésie. Face aux gigantesques besoins en capitaux de ce marché en plein essor, de nouveaux acteurs mondiaux se mobilisent.

Encadré 1. L’investissement des grands fonds financiers dans les centres de données

Nécessitant d’énormes capitaux, le marché des centres de données attire les grands fonds financiers d’investissements à la recherche de diversification, de rentabilité et de sécurité à moyen et long terme, en particulier de l’Anglosphère (Blackstone, Morgan Stanley, Digital Bridge, Brookfield, Macquarie Asset Managment...) ou du golfe Persique (fonds d’investissement MGX des Émirats Arabes Unis, Arabie saoudite...). Le fonds étasunien Blackstone veut ainsi porter à 1 000 milliards de dollars en cinq ans ses investissements, en rachetant par exemple en 2024 l’australien AirTrunk présent en Asie-Pacifique à Sydney (3 sites), Melbourne (1), Tokyo (2), Osaka (1), Hong Kong (2), Singapour (1) et en Malaisie (1). On voit aussi apparaître certains fonds de pension, en charge du financement des retraites, comme l'Office d'investissement du régime de pensions du Canada (Investissements RPC) qui couvre 22 millions d’actifs et de retraités. En janvier 2025, le projet Stargate d’OpenAi, Oracle et du japonais Softbank mobilise entre 100 et 500 millions de dollars.

1.2. Des entrepôts discrets, stratégiques, aux fortes contraintes mais avec peu d’emplois

On peut considérer un centre de données comme un coffre-fort de données numériques. Automatisé, ce site de stockage ou d’entreposage, de traitement et de distribution de données numériques mobilise peu d’emplois, souvent peu qualifiés. Extérieurement, il est souvent d’un aspect assez austère. Le bâtiment, fermé sur lui-même et ceinturé de grilles ou de hauts murs, n’a pas ou peu d’ouvertures extérieures ; il est protégé contre toute menace ou intrusion par des équipes de sécurité et des systèmes ultrasécurisés (détecteurs d’empreintes, reconnaissance faciale, badgeuses, sas unipersonnel, système de vidéo surveillance à 360°...). Dans les études statistiques sur ce secteur, le centre de données est un établissement qui est défini par la surface (m²) de ses salles, la puissance électrique (MW) dont il dispose pour fonctionner et ses capacités de stockage et de connexion au réseau internet. Il est organisé autour de deux grands blocs.

À l’intérieur du bâtiment, son noyau est composé d’une succession de salles où se trouvent les équipements informatiques stratégiques : rangées de serveurs assurant le traitement des données et les calculs, systèmes de stockage des données sur disques, infrastructure réseau (commutateurs, routeurs...) et logiciels... On est frappé en entrant dans l’une d’elle par la relative obscurité, les clignotements permanents de milliers de petites lumières derrière les baies des racks des serveurs, un important bruit de fond permanent, la chaleur et une relative humidité et, surtout, l’absence de tout être humain du fait de l’automatisation des opérations. D’une durée de vie de 4 à 5 ans, les serveurs répondent aux requêtes des clients en fournissant des services aussi différents que l’accès au Web, le courrier électronique, le stockage de données (textes, graphiques, scripts, fichiers multimédias, portails, sites web...), la gestion de la sécurité (authentification, contrôle d’accès...), les logiciels d’application...

Encadré 2. Les pannes de centres de données : du « cloud computing » au retour au réel

Historiquement, les besoins matériels en infrastructures – tout comme leurs localisations géographiques dans un espace concret – ont longtemps été masqués par les acteurs de l’informatique en ligne – que l’on peut définir comme l’utilisation de serveurs informatiques à distance hébergés dans des centres de données connectés à internet. Et ce, malgré son essor considérable dans les entreprises et les administrations à partir des décennies 1990/2000, puis chez les particuliers dans les années 2000/2010. L’usage métaphorique du terme de « nuage » (« cloud » computing) est ainsi lancé en 1994 par la firme étasunienne General Magic, puis repris par Compaq en 1996 avant d’être systématisé. Bien qu’omniprésentes, ces infrastructures demeurent donc souvent pour les usagers invisibles (« transparentes »), leur existence n’étant révélée que lors de pannes ou de dysfonctionnements des supports ou réseaux. C’est seulement alors que la matérialité des systèmes techniques et la territorialisation des supports et réseaux portant la révolution numérique apparaissent aux yeux des usagers.

Ainsi en 2017, la panne d’AWS Amazon Kinesis, un service cloud dédié au traitement en temps réel d'importants flux de données, avait touché la Côte Est des États-Unis, mettant hors service des milliers de sites Web, dont ceux de Netflix, Slack, Medium ou de la Securities and Exchange Commission (SEC)… Le 30 août 2020, un des principaux fournisseurs d'accès à Internet (FAI), l’américain CenturyLink, connaît une panne de réseau du fait de la défaillance de l’un de ses centres de données situé à Mississauga (Ontario, Canada) : elle provoque d'importants problèmes de connexion pour au moins 10 000 clients majeurs, dont tous les opérateurs de rang 1 qui constituent l'épine dorsale d'Internet comme Microsoft, Twitter, Amazon, Cloudlfare, Electronic Arts (EA), eBay, Starbucks, Blizzard, Steam, Discord ou Reddit. Cet incident entraîne une baisse de 3,5 % du trafic internet mondial. En 2020, le centre de Roubaix d’OVHCloud, l’un des principaux hébergeurs français, a connu une panne qui touche les fonctionnalités en ligne des jeux vidéo Call of Duty, Origin, Minecraft et Cloudfare. Aujourd’hui la multiplication des attaques criminelles contre ces équipements est devenue un enjeu majeur de sécurité (cf. infra).

À l’extérieur se trouvent les équipements fournissant l’alimentation électrique (générateurs de secours, batteries, appareillages de commutation/transformateurs...) et les infrastructures de refroidissement. Contre la chaleur créée par le fonctionnement des systèmes, le maintien d’une température interne autour de 25°C est vital au bon fonctionnement des équipements ; le site a donc besoin de climatiseurs, d’unités de traitement de l’air, de tuyauteries d’eau réfrigérée... Un centre de données fait donc face à de fortes contraintes techniques, en particulier s’il abrite des fonctions stratégiques (données des services de sécurité...). Un site de rang Tier 3 doit ainsi avoir une disponibilité assurée de 99,98 %, soit une tolérance maximale de 1,6 heure de panne dans l’année. Les équipements sont donc doublés ou triplés, afin de faire face à toute panne. Géographiquement, un site de données doit bien sûr éviter les zones inondables, les risques volcaniques ou sismiques, les menaces de pollutions chimiques ou les effets électromagnétiques.

Encadré 3. Redondance des équipements, autonomie et sécurité des données : l’exemple d’un centre

Ouvert récemment, un centre de donnée situé en Seine-Saint-Denis est fourni en électricité à l’échelle régionale par trois postes électriques différents, eux-mêmes répartis sur deux boucles moyenne et haute tension qui sont alimentées par deux lignes haute tension de 90 000 volts enterrées. Dans le centre lui-même, des groupes électrogènes doivent pouvoir prendre la relève et fonctionner plusieurs heures en autonomie en cas de rupture d’approvisionnement électrique extérieur. Ces groupes électrogènes sont alimentés par d’importantes réserves de fioul présentent à l’intérieur du site. Le site de Digital Realty de La Courneuve est ainsi équipé de 72 groupes électrogènes d’une puissance de 356 MW alimentés par 36 cuves enterrées comportant 750 000 litres de fioul.

Au total, il représente un investissement financier considérable, son coût de construction pouvant atteindre en Virginie (États-Unis), selon sa taille, entre 420 et 800 millions de dollars. Le site Equinix PA13 de Meudon dans les Hauts-de-Seine a coûté 350 millions d’euros pour 7 000 m² de salles sur un terrain de 14 000 m² employant seulement 30 salariés permanents.

En effet, ces entrepôts automatisés nécessitent un faible nombre d’emplois, souvent peu qualifiés (petit secrétariat, maintenance et, surtout, gardiennage) et emblématiques à la fois de la prolétarisation de certaines tâches banales et du profond dualisme social et technique des dynamiques technologiques. Si les promesses de créations massives d’emplois sont souvent utilisées par les firmes auprès des élus et des populations afin d’arracher leur accord, elles sont un leurre.

On mélange souvent les emplois temporaires nécessaires à la construction et les emplois pérennes liés au fonctionnement du site. Aux États-Unis, si la phase de construction d’un centre de 100 MW de puissance crée 500 emplois pendant deux à trois ans, le site mobilise ensuite seulement 50 salariés directs pour fonctionner durant ses vingt ans de phase opérationnelle. L’US Bureau of Labor Statistics des États-Unis estime d’ailleurs que l’emploi dans les centres de données est passé de seulement 306 000 à 501 000 salariés entre 2016 et 2023. En France, ils représenteraient 28 000 emplois directs, moins que le secteur du chocolat (30 000 emplois, source). Du fait de son haut degré d’automatisation, ce type d’entrepôts mobilise au m² un faible nombre de postes ; la majeure partie des salariés qui viennent y travailler appartiennent aux entreprises louant les locaux ou les équipements, ce qui suppose de bonnes liaisons en transport (métro, train, autoroute). Les effets d’entraînement économique local d’un centre de données sont donc minimes.

1.3. Centres fermés ou ouverts : la question de la protection de fonctions stratégiques

Les centres de données sont divers selon leur fonction, leur type, leur taille, leur capacité énergétique et leur localisation. Il convient de distinguer les centres fermés, qui ne sont en général pas pris en compte dans les statistiques et échappent donc souvent au radar, des centres ouverts, ou « publics ».

Les centres de données fermés – ou internes – sont des installations uniquement réservées à un acteur, propriétaire ou locataire du site, du fait de choix stratégiques de confidentialité ou de conformité réglementaire. Il s’agit d’acteurs majeurs souhaitant garder la main sur tout ou partie de leurs données (par exemple Coca Cola, ExxonMobil, Procter & Gamble, Walmart...), en particulier dans des secteurs sensibles comme la finance (Bank of America, JPMorgan Chase, Swift...), l’aérospatial (CNES, Airbus et EADS Astrium à Toulouse...) ou l’armement (Thalès à Élancourt ou à Mérignac, site du CEA – direction des Applications Militaire dans l’Essonne...). Le cas de la NSA étasunienne est sans doute le plus emblématique.

Encadré 4. L’Utah Data Center de la NSA étatsunienne : un des plus importants sites de la première agence mondiale d’espionnage

La National Security Agency (NSA) étasunienne fait face à un défi majeur : stocker, traiter et sauvegarder les énormes masses de données produites en permanence par la communauté du renseignement des États-Unis, qui réunit 18 agences et services ministériels spécialisés (CIA, Défense, Énergie, Sécurité intérieure, Justice, Trésor...). Dans la banlieue de Washington (Maryland), elle dispose de deux complexes : son siège de Fort Meade (55 000 salariés sur 2 000 ha.) et, moins connu, le site de Linthicum, à 25 minutes de route vers le nord-est (12 000 salariés sur 93 000 m²) dans lequel se trouve un grand centre de données. Mais pour répondre à des besoins croissants (postes d’écoutes des télécommunications dans le monde par le réseau Echelon, branchements sur les fournisseurs d’accès à Internet, données satellites, reconnaissance faciale...), un nouveau centre de données est ouvert à Camp Williams, au sud de l’aire urbaine de Salt Lake City (Utah), dans le cadre de la CNCI – Comprehensive National Cybersecurity Initiative – lancée par George W. Bush en janvier 2008.

Hypersécurisé, le site de Camp Williams aligne sur 1,6 km une série de gigantesques bâtiments abritant les serveurs informatiques, les systèmes de communication, les services administratifs et de sécurité, la station électrique et 60 générateurs de secours d’une autonomie de trois jours en cas de panne et enfin la station de réfrigération. Cet équipement a couté 3,2 milliards de dollars, dont 40 % pour les bâtiments et 60 % pour les équipements. Il exige une puissance électrique de 65 mégawatts et consomme 485 millions de litres d’eau pour son refroidissement. Lors de son ouverture, le magazine Forbes estimait qu’il mobilisait 10 000 racks de serveurs disposant d’une capacité de stockage de 3 et 12 exaoctets (milliards de giga-octets). Le site est doté d’un supercalculateur Cray XC30 développé avec la DARPA, alors l’un des plus puissants ordinateurs au monde qui pouvait réaliser 100 000 milliards de calcul à la seconde et d’algorithmes de traitement et de cryptage (ou cassage de codes) ultrasophistiqués. Sa structure et sa composition sont évidemment tenues secrètes.

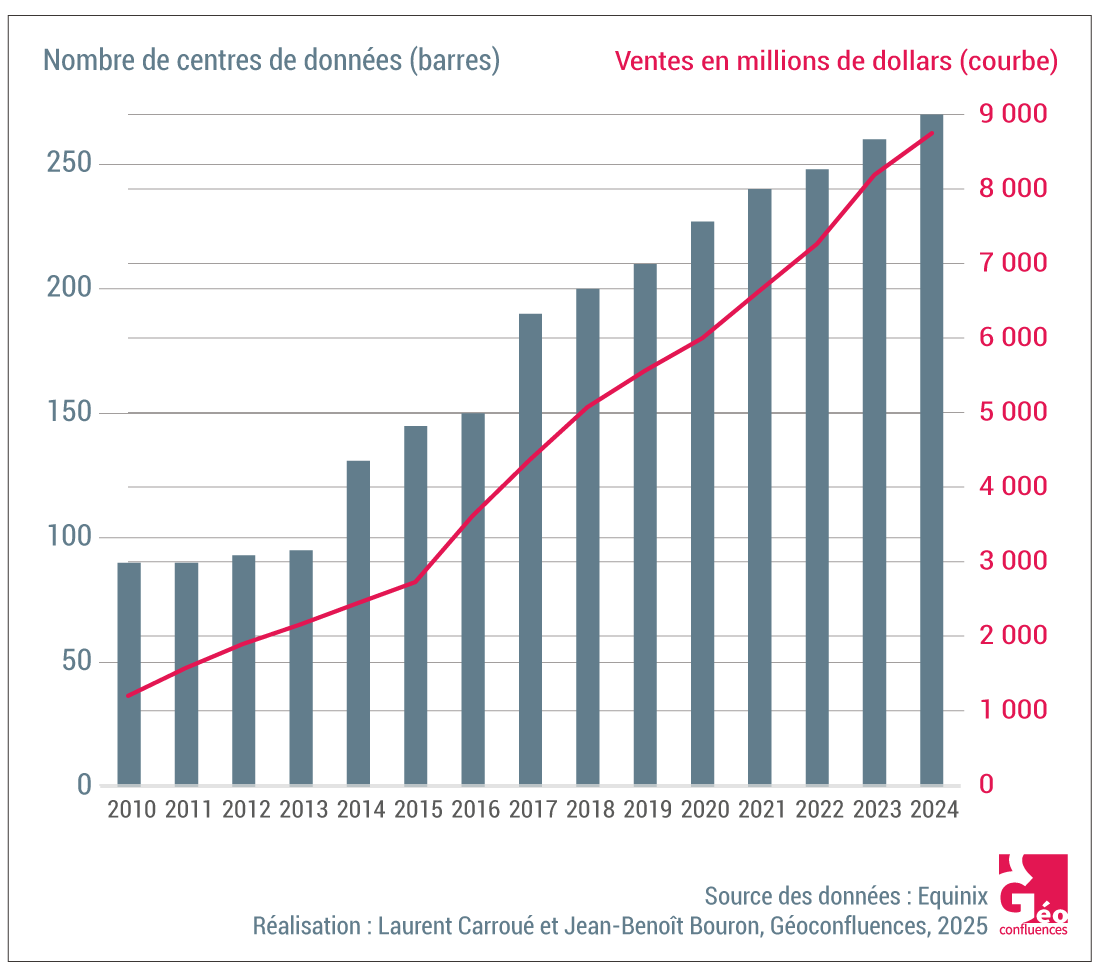

Les centres ouverts ou de colocation. Si, dans les années 2000, les centres de données fermés ou internes hébergeaient 85 % des serveurs, leur poids s’est depuis beaucoup réduit devant l’externalisation des activités auprès d’une dizaine de fournisseurs mondiaux spécialisés. Ainsi, JPMorgan Chase, 5e banque mondiale, réduit de 32 à 17 ses centres de données dans le monde au profit de centres loués à AWS, Google et Microsoft. Dans le commerce, le géant Walmart met en place un dispositif hybride avec deux centres internes (Colorado, Missouri) et fait appel à des centres de Microsoft et Google. Ces sites ouverts, ou « publics », sont des centres en colocation dans lesquels un client loue soit des serveurs déjà installés, soit un espace dans lequel il installe ses propres serveurs. Les centres de colocation, dont les hyperscales (cf. infra), passent de 24 % à 74 % de l’offre mondiale entre 2014 et 2023, et sans doute 85 % d’ici 2028.

Si les géants du net multiplient leurs propres centres de données, ils font souvent aussi appel à d’autres opérateurs : lancée dès 2017, AWS en Île-de-France mobilise les centres de trois fournisseurs dans lesquels il loue des locaux : Data4 à Marcoussis, Scaleway à Vitry-sur-Seine et Digital Realty à La Courneuve. Dans ce contexte, on voit apparaître de nouvelles sociétés spécialisées peu connues du grand public mais disposant d’une capacité d’action d’échelle mondiale, tels les deux géants étasuniens Digital Realty (308 sites, 29 États) ou Equinix (270 sites, 33 États).

Document 3. Equinix, un géant mondial de la colocation des centres de données

1.4. Les centres de données : des nœuds insérés dans de puissants réseaux de télécommunication

Les centres de données sont des nœuds techniques intégrés dans des réseaux de télécommunication hiérarchisés et sélectifs qui couvrent l’espace géographique mondial. Le fonctionnement du système internet présente un certain nombre d’exigences techniques ayant un impact territorial majeur sur la géographie des centres de données : efficience et puissance, grâce à la fibre optique, assurant des temps de latence – terme qui définit le temps nécessaire au transfert de données numériques dans l’espace géographique entre un point d’origine et un point de destination – les plus brefs possibles (comme pour l’offre de vidéo en streaming).

Si les médias mettent souvent en lumière l’importance des réseaux sous-marins, il convient de porter attention aux effets d’échelle et aux effets de loupe : le réseau terrestre mondial de fibre optique est dix fois plus étendu que le réseau maritime et mobilise 62 % des investissements en 2024 (maritime : 38 %). La première fonction du réseau maritime est bien d’interconnecter au-delà des mers et océans les réseaux terrestres entre eux, d’où l’importance stratégique des points d’atterrissement littoraux comme sites d’interface polarisant souvent dans leur hinterland régional de nombreux centres de données (Virginie ou Oregon aux États-Unis, Marseille en France...).

L’efficacité de la connexion internet offerte aux clients, entreprises ou particuliers, par les centres de données est un enjeu territorialement sélectif qui aboutit à la création de regroupements spécialisés – ou clusters – dans les espaces métropolitains ou régionaux les mieux équipés en fibres de grande puissance (cf. infra). Enfin, pour répondre au mieux à l’explosion des flux internet qui saturent les réseaux et congestionnent la bande passante, on assiste à un processus de déconcentration dans l’espace mondial de l’offre de certains contenus via la création de centres de données spécialisés, les CDN (centres de diffusion de contenu).

Encadré 5. Les CDN ou Centres de Diffusion de Contenus : déconcentrer pour alléger les réseaux internet

En vingt ans se sont multipliés les CDN, centres de diffusion de contenu. Leur objectif est de répondre à la congestion des bandes passantes dans l’espace mondial du fait de l’explosion des flux en créant des centres de données secondaires, continentaux ou régionaux. Plus proches des utilisateurs finaux, ils ont deux fonctions : réduire la distance physique, donc les temps de latence des consultations ou des chargements ; mieux équilibrer géographiquement les charges supportées par le réseau internet mondial. Ces groupes de serveurs périphériques stockent des copies de fichiers mises en cache – textes, graphiques, scripts, fichiers multimédias, pages web, commerce électronique, streaming vidéo et réseaux sociaux... – issues des serveurs centraux d’origine, qui contiennent la version originale et en assurent la mise à jour régulière.

Les GAFAM peuvent ainsi placer dans un centre de données situé en Europe, en Asie ou en Amérique latine un double des contenus mis en ligne aux États-Unis à destination de leurs clientèles continentales. Google organise son offre – Gmail, Google Drive, GoogleMaps, Google Photos, Google Play, Search ou YouTube... – à destination de millions de clients en partageant l’espace mondial en 42 régions continentales (Europe, Asie, Australie...) et sous-continentales, elles-mêmes découpées en 127 zones, qui mobilisent chacune au moins trois centres de données physiques, et plus de 200 CDN. Ces choix territoriaux n'ont rien d’anecdotique lorsqu’on sait qu’en France, par exemple, les GAFAM mobilisent à eux seuls 40 % de la bande passante, dont Netflix (15 %), Google (10 %), Meta (7 %) et Amazon (7 %). Ce seul chiffre illustre concrètement leur poids et leur influence. Au total, les fournisseurs de CDN comme Amazon CloudFront, Akamai Technologies, AT&T, Cloudflare, etc., distribuent plus de la moitié du trafic internet mondial.

D’autres acteurs, infrastructures et sites, inconnus du grand public, jouent comme les CDN un rôle stratégique dans l’articulation entre l’internet et les centres de données. Premièrement, les Points d’Échange Internet (PEI ou IXP, Internet Exchange Point) sont des sites physiques par lesquels les 220 principaux opérateurs des services Internet se connectent entre eux via des points d’accès (POP). Ils jouent un rôle majeur dans la création des clusters de centres de données, en particulier dans les espaces métropolitains. Deuxièmement, les Centres d’Élimination des Attaques, ou scrubbing centers, qui sont spécialisés dans la lutte contre le piratage numérique et les cyberattaques.

Encadré 6. Assurer la sécurité des réseaux et des flux : les scrubbing centers, centres d’élimination des attaques

Face à l’explosion de cyberattaques de plus en plus sophistiquées (extorsion de fond, demande de rançon, paralysie des réseaux, vol de données...) de la part de pirates informatiques, d’organisations criminelles, voire d’États, la sécurisation des données stockées est devenue un problème central. Si les fonctions de contrôle et de protection sont proposées dans certains centres de données, il est souvent fait appel à un « centre de scrubbing » (nettoyage, lessivage) qui reçoit et filtre le trafic réseau afin de supprimer tout attaque. En 2023, le groupe GTT – qui dispose de 10 centres de scrubbing en Europe, en Amérique du Nord et en Asie-Pacifique – ouvre un centre à Madrid, car c’est une plaque tournante reliant l’Espagne à l’Amérique latine, à l’Afrique et à l’Asie-Pacifique. Akamai, une entreprise de Boston née du MIT et spécialisée dans la cybersécurité, dispose de 36 centres de nettoyage dans le monde (par exemple Mumbai et Chennai pour l’Inde). Elle est l’un des principaux diffuseurs du trafic internet en étant en interconnexion avec plus de 1 400 opérateurs de réseaux grâce à 4 200 implantations géographiques dans le monde. Elle gérerait au total plus de 20 % de l’internet mondial, devant Cloudflare, Fastly ou Limelight. Totalement méconnues du grand public, ces entreprises jouent un rôle majeur dans la sécurisation du trafic sur les réseaux à destination des centres de données.

2. La révolution de l’intelligence artificielle : la course au gigantisme des centres géants ou hyperscales

La structure et la géographie des centres de données sont bouleversées dans les années 2020 par une innovation de rupture : la révolution de l’intelligence artificielle, ou IA. Du fait de contraintes techniques exceptionnelles et de nécessaires économies d’échelle dues à des coûts financiers de plus en plus extravagants, une poignée de firmes géantes étasuniennes ou chinoises, en position de quasi-oligopole mondial, se lancent dans une course au gigantisme à travers la multiplication de centres de données géants, les hyperscales.

2.1. L’IA : la mobilisation d’immenses besoins de calculs et de stockage

Le lancement public, le 30 novembre 2022 de ChatGPT – pour « generative pre-trained transformer » en anglais – par la firme OpenAI, fondée en 2015 par Sam Altman à Palo Alto dans la Silicon Valley, symbolise auprès du grand public l’irruption de l’intelligence artificielle. L’usage des robots conversationnels (chatbots) connaît depuis lors un boom phénoménal, tandis que se multiplient les offres de modèles de langage géants : Claude d’Anthropic, Gemini de Google, Copilot de Microsoft, Llama de Meta, Grok d’xAI d’Elon Musk, MyAI de Snap, Le Chat de Mistral AI, R1 du chinois Deepseek, Qwen2.5 Max d’Alibaba... Les robots conversationnels sont des outils capables à la demande de rédiger des messages, de répondre à des questions, de générer des contenus (code, texte, image, vidéo, musique...) ou de fournir des données scientifiques. L’essor de l’IA repose sur des puissances de calcul phénoménales jamais usitées jusqu’ici pour le grand public.

Encadré 7. Faire tourner les modèles de l’IA : la mobilisation de gigantesques ressources

L’IA tire sa puissance de l’agrégation et du traitement de milliards de données. Afin d’améliorer les performances de leurs grands modèles de langage (LLM, large language model) et de réduire les taux d’erreur de leurs prédictions, ou prises de décision, les firmes mobilisent les immenses ressources stockées dans les centres de données (ouvrages, travaux de recherche, presse, encyclopédies...) accessibles via internet. Ainsi, le nombre de paramètres d'entraînement d’OpenAi passe en quelques années de 117 millions pour GPT-1, à 175 milliards pour GPT-3 puis 1 700 milliards pour GPT-4. Le chinois DeppSeek-v3 est un modèle à 671 milliards de paramètres. Les capitaux à mobiliser sont donc énormes : développer GPT-4 a couté 100 millions de dollars, le futur GPT-5 pourrait coûter un milliard de dollars.

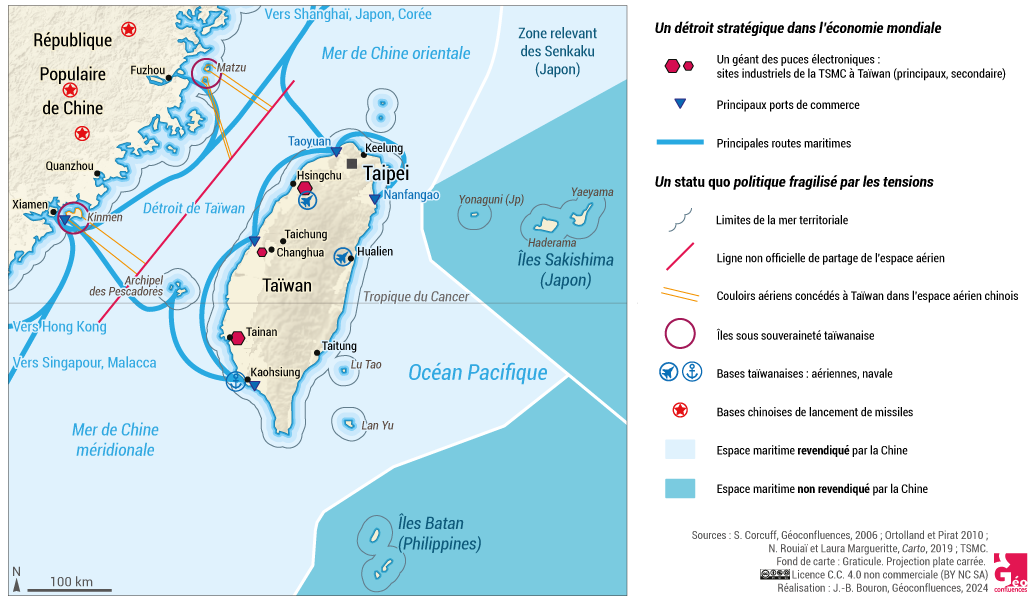

Ceci s’explique en particulier par le recours à des composants électroniques spécifiques : des puces graphiques (GPU) performantes. Historiquement, leur essor est récent : entre 2021 et 2024, les vente de Nvidia sont multipliées par 7 et les centres de données représentent aujourd’hui 77 % de ses ventes mondiales. Les H100 et H200 que conçoit Nvidia dans ses laboratoires de la Silicon Valley sont fabriquées ensuite en sous-traitance à Taïwan par TSMC dans ses usines de composants d’Hinshu. Le superordinateur Colossus de xAI (Grok, Aurora) d’Elon Musk – dont le siège est à San Francisco – contient 100 000 puces GPUs H100 de Nvidia pour faire tourner le modèle Grok-3. Tout le secteur de l’IA est donc étroitement dépendant de la chaîne de conception et de production des semi-conducteurs où Nvidia est en quasi-monopole mondial (80 %) et impose donc des prix jugés souvent exorbitants (plus de 40 000 dollars l’unité) du fait des pénuries actuelles liées à l’incapacité de TSMC de répondre à la demande. Une de ses lignes de production coûte de 15 à 20 milliards de dollars et demande deux ans de délai pour sa construction. Face à Nvidia, d’autres acteurs se lancent dans la conception de leurs propres composants, par exemple IA Trainium2 d’AWS pour Amazon Nova. Ces puces sont si stratégiques que le président des États-Unis Joseph Biden a restreint, à l’automne 2025, les possibilités d’exportations de ces processeurs vers 120 pays « afin de garantir la sécurité et la puissance économique des États-Unis à l’ère de l’intelligence artificielle », en particulier contre le concurrent qu’est la Chine. La seconde présidence Trump, ouverte en janvier 2025, exacerbe la rivalité scientifique et technologique entre États-Unis et Chine en tentant de bloquer l’accès aux composants majeurs de l’IA.

Enfin, il convient de souligner qu’une requête sur un LLM va conduire à un « apprentissage profond » (« deep learning ») sans supervision humaine effectuant des milliards d'opérations itératives avant de fournir une réponse, plus ou moins utile au requérant. Ceci explique qu’une requête sur ChatGPT consomme dix fois plus d'électricité (2,9 wattheures - Wh) qu'une simple recherche sur Google (0,3 Wh) par exemple.

Document 4. La production de puces électroniques par TSMC à Taïwan

Document 5. NVIDIA : le poids croissant des puces pour les centres de données dans les ventes mondiales

| Ventes en milliards de dollars | 2015;2016;2017;2018;2019;2020;2021;2022;2023;2024 | true | ||

| Centres de données | 0.317;0.339;0.83;1.932;2.932;3;6.7;10.613;15.005;47.225 | #e31e51 | ||

| Autres secteurs | 4.365;4.671;6.08;7.782;8.788;7.92;9.98;16.301;11.969;13.697 | #cccccc |

Source : Nvidia

2.2. La multiplication de centres géants : les hyperscales

Face à ces nouveaux et énormes besoins de stockage et de calcul, les grands acteurs du cloud – ou hyperscalers, tels AWS, Microsoft Azure, Google Cloud, Meta Plateforms, Digital Realty, CloudHQ... – se lancent dans la construction de centres de données géants, ou hyperscale. On change là complètement d’échelle technique, économique et financière par rapport aux centres de données classiques. Coûtant parfois plus d’un milliard de dollars, ces sites contiennent des milliers de racks et des dizaines de milliers de serveurs. En 2025, Meta lance la construction d’un des plus grands centres mondiaux de données (372 000 m²) à Monroe, dans le Nord-Est de la Louisiane, au prix d’un investissement de 10 milliards de dollars, qui doit ouvrir en 2030. Aux États-Unis, la taille moyenne des centres de données doit passer de 40 à 60 MW d’ici 2028, avec un tiers des installations constitué de gigantesques campus de plus de 200 MW.

Document 6. Comparaison entre quatre types de centres de données : la course au gigantisme

| Petits | Moyens | Géants hyperscales | Monstres Colossus Grok3 |

|

| Superficie en m² | 450 à 1 800 | 1 800 à 9 300 | 9 300 à 93 000 | 372 000 |

| Nombre de serveurs | 500 à 2 000 | 2 000 à 10 000 | 1 000 à 100 000 | En projet |

| Capacité électrique | 1 à 5 MW | 5 à 20 MW | 10 à 100 MW | 1,2 GW |

| Exemple de firme | Equinix | Digital Realty | AWS Amazon | xAI d’Elon Musk |

D’après dgtlinfra.com

Au total, les principaux acteurs du secteur vont mobiliser environ 1 800 milliards de dollars d’investissements entre 2025 et 2030 pour faire face à l’essor de la demande mondiale en puissance de calcul. Mais ce processus se heurte à de nombreux obstacles : aux goulots d’étranglement dans la production des équipements chez les fournisseurs répond sur les lieux d’implantation l’insuffisance ou la fragilité des réseaux de télécommunication et des infrastructures électriques.

Document 7. Les deux centres de données géants de Saint-Denis et la Courneuve en Île-de-France

|

Le campus de centres de données d’Equinix à la Plaine Saint-Denis (93). Situé rue Ambroise Croizat, à Saint-Denis, Equinix PA2 est l’un des plus importants de France. Son emprise foncière est presque équivalente au Stade de France. On assiste à la création d’un puissant cluster régional avec des connections en fibres optiques aux pôles d’Aubervilliers (PA6 et PA5), Pantin (PA4 et PA8X) et Courbevoie (PA7). |

Digital Realty : Paris Digital Park, un nouveau centre de données géant. Situé à la Courneuve, avenue Marcel Cachin, le long de l’autoroute A6 à seulement 3 km de Paris, le Paris Digital Park sera l’un des plus importants centres de données de France (130 MW, 40 000 m² de salles) au moment de son achèvement. Il est construit par le géant étasunien Digital Realty sur une ancienne friche industrielle (usines Eurocopter, hélicoptères civils et militaires). Ce vaste campus regroupe sur un même site à l’architecture futuriste de 250 m de diamètre les bâtiments de quatre centres de données autonomes : PAR8, PAR9, PAR10 et PAR11. Devant le succès de son offre et l’augmentation de la demande, Digital Realty lance en 2025 le projet d’un nouveau centre de données géant à Dugny (ouverture prévue de 2027 à 2030). À 3,2 km au nord-est de la Courneuve, le site est une ancienne friche militaire de 10 ha en bordure de l’aéroport du Bourget. Représentant deux milliards d’euros d’investissement, ce campus de 200 mégawatt correspond à 20 % de la production électrique d’un EPR. Il sera moitié plus puissant que le Paris Digital Park de La Courneuve présent sur l’image satellite, soulignant ainsi la course au gigantisme que connaît le secteur des centres de données |

3. Des enjeux énergétiques, territoriaux et géopolitiques brûlants

L’essor des centres de données pose en effet à toutes les échelles de nombreuses questions, tant énergétiques et environnementales que territoriales ou géopolitiques. Ces supports du cyberespace cristallisent en effet de nombreuses et intenses rivalités de pouvoirs.

3.1. Un système énergétivore face aux enjeux environnementaux et territoriaux

Alors qu’un site moyen de 10 000 m² consomme, uniquement pour se refroidir, autant d’énergie qu’une ville de 50 000 habitants, la disponibilité en électricité de haute qualité – c’est-à-dire efficace, sans discontinuité, 24h/24 – au plus bas prix possible demeure un critère géographique de localisation sélectif, comme le rappellent les baisses de tension, les délestages ou les coupures de courants dans de nombreux pays. De plus, l’essor de l’IA entraîne une explosion spectaculaire de la consommation électrique : selon l’Agence Internationale de l’Energie (IEA, 2025), elle devrait passer à l’échelle mondiale de 460 à plus de 1 000 térawattheures (TWh) entre 2022 et 2026, une demande équivalente à la consommation d’électricité du Japon. Selon le Département de l’Énergie (Shehabi, 2024), la consommation des centres de données aux États-Unis a déjà triplé entre 2014 et 2023 de 58 à 176 TWh et pourrait atteindre les 580 TWh en 2028, soit passer 4,4 % à 12 % de la consommation nationale électrique totale. En Europe, elle devrait tripler d’ici 2030.

Dans ces conditions, l’essor des centres de données est incompatible avec les engagements de lutte contre le changement climatique et un bilan carbone Net-Zero pour 2050, malgré une efficacité énergétique croissante qui réduit d’environ 40 % en quinze ans la consommation d’un centre. En 2023, les centres rejetteraient l’équivalent de 2,5 milliards de tonnes de CO2, soit presque autant que toutes les émissions de l’Inde (2,7 milliards de tonnes). L’empreinte carbone des sites varie beaucoup d’un État ou d’une région à l’autre selon les énergies utilisées. Aux États-Unis par exemple, les différences sont considérables entre États fédérés. La Virginie (199 tonnes de CO2 par MWh, soit la puissance électrique installée), le Texas (117 t), la Californie (116 t), puis l’Ohio (66 t) et l’Illinois (64 t) sont ainsi de gros pollueurs.

Alors que l’arrivée au pouvoir à la Maison blanche de Donald Trump en janvier 2025 pour un second mandat signifie la liquidation de toute politique publique de protection de l’environnement aux États-Unis (slogan de campagne : « drill, Baby, drill », suspension du « New Deal vert » de Biden...), on assiste d’un côté à la relance du charbon et du nucléaire, de l’autre à l’essor du gaz de schiste pour répondre aux nouveaux besoins. À Kansas City, les besoins de Meta sont si importants que la fermeture d’une centrale électrique au charbon est suspendue.

Encadré 8. Les projets de centres géants des Gafam : l’attrait du gaz de schiste du Texas

La révolution du gaz de schiste intervenue ces dernières décennies aux États-Unis se traduit par un recours croissant à cette énergie, polluante mais souple d’emploi et facile à mettre en œuvre lors de la création de sites géants. Ainsi, le nouveau site Colossus qui doit entraîner Grok 3, le modèle de langage de xAi d’Elon Musk, est ouvert sur une ancienne friche industrielle d’Electrolux sur le Mississippi dans la banlieue sud-ouest de Memphis (Tennessee) qui a l’avantage d’être desservi par un gazoduc. Le site est doté lors de son lancement en septembre 2024 de 100 000 processeurs GPU Nvidia H100, nécessitant une puissance électrique de 150 MW, de quoi alimenter 100 000 foyers, acceptée par la Tennessee Valley Authority (centrale à gaz, hydroélectricité et nucléaire). En décembre 2024, sa capacité est doublée à 200 000 GPU, soit 250 MW. Au total, le projet devrait être porté à 1,2 GW (1 200 MW). Pour faire face, Elon Musk décide de financer une nouvelle sous-station électrique et d’implanter des centaines de turbines à gaz supplémentaires.

En janvier 2025, Donald Trump annonce un immense projet d’IA, Stargate, devant mobiliser 500 milliards de dollars sur cinq ans : « Nous allons entrer dans l’âge d’or de l’Amérique » et « barrer la route à la Chine » et aux « autres concurrents ». Stargate mobilise les capitaux du japonais Softbank, qui en prend la présidence, et du fonds émirati MGX, et les technologies des Étatsuniens OpenAi et Oracle. La construction du premier des 50 campus prévus est lancée à Abilene (Texas) avec dix bâtiments de 50 000 m². Il est prévu d’y construire une centrale électrique au gaz d’un coût de 500 millions de dollars pouvant fournir 360,5 MW d’énergie. Une partie de l’énergie pourrait aussi venir en complément des trois projets d’énergie solaire Orion développés dans le Comté de Milam au nord-Est d’Austin par SB Energy, une filiale du japonais Softbank.

Dans le même temps, un nombre croissant de sites alimentent en retour, le plus souvent gratuitement, des réseaux de chauffage urbain (logements, piscines...) dans les grandes métropoles : AWS à Tallaght à l’ouest de Dublin, Stockholm Data Parks, Saint-Denis, Marseille, Lisses ou le plateau de Saclay en France... C’est aussi une façon de répondre aux vives réticences ou aux critiques dont les centres de données font l’objet et de renforcer l’acceptation sociale de leur implantation locale.

Encadré 9. Le grand retour de l’énergie nucléaire comme réponse aux goulets d’étranglement

Face à leurs besoins, les géants du numérique se tournent vers l’énergie nucléaire. Microsoft signe ainsi un contrat de 26 ans avec Constellation Energy afin de réouvrir le réacteur 1 de la centrale nucléaire de Three Mile Island, fermée depuis l’accident qui ravagea de réacteur 2 en 1979. En Virginie, le Pennsylvania Data Center Campus d’AWS est directement connecté à la centrale nucléaire de Susquehanna gérée par Talen Energy. Dans la région des Grands Lacs, la centrale de Palisades d’Holtec International, proche de Chicago sur le Lac Michigan, fermée en 2022, va être réouverte en 2025. Dans ce contexte, la Nuclear Regulatory Commission étasunienne donne son feu vert au développement – qui va prendre cependant plusieurs années – de petits réacteurs modulaires (SMR « à eau légère » de 25 de 400 mégawatts électriques (MWe), contre 900 à 1600 MWe pour une centrale traditionnelle). Standard Power veut ainsi installer d’ici 2029 dans l’Ohio et la Pennsylvanie. Dans le Nord-Ouest, Google signe un partenariat avec Energy Northwest, une société publique d’exploitation bien implantée dans l’État de Washington, pour la construction et l’exploitation de quatre premiers SMR générant 320 MWe et prévoit déjà à moyen terme de tripler ces capacités.

La disponibilité en électricité devient ainsi un facteur de localisation majeur des centres de données dans les territoires face aux pénuries ou aux tensions locales et régionales. Aux États-Unis, la situation est particulièrement délicate dans les quinze États fédérés polarisant 80 % des besoins (Virginie, Atlanta, Phoenix, Californie...). Dans le Comté de Maricopa (Arizona), la demande électrique doit augmenter de 40 % d’ici 2030. En Virginie, où les centres de données accaparent déjà 26 % de la consommation totale d’électricité, Dominion Energy estime que les besoins vont quadrupler d’ici 2035, soit l’équivalent de la consommation de 8,8 millions de foyers supplémentaires. Alors que le projet de 5,2 milliards de dollars de renforcement des lignes à haute tension pour mieux desservir les gigantesques besoins de la « Data Center Alley » se heurte à de nombreuses résistances locales.

Encadré 10. La Silicon Valley : une forte dépendance extérieure, des prix exorbitants

Dans la Silicon Valley, la demande énergétique des centres de données doit doubler dans les quinze prochaines années alors que dans le même temps le parc automobile électrique doit tripler. Sans ressources naturelles locales, la région doit aller chercher son électricité dans un rayon de 500 km, des barrages hydroélectriques de la chaîne des Cascades au nord dans l’État de Washington aux fermes solaires du désert de Mojave au Sud-Est. Alors que l’éolien et le solaire ne fournissent que 13 % de l’énergie, le gaz naturel et l’hydroélectricité jouent un rôle majeur. Alors que les centres de données consomment 60 % de l’énergie régionale, les tentatives de stockage d'énergie par batterie lithium-ion (BESS) à grande échelle sont en échec technique et financier. Cette situation de tension et de pénurie relative y explique que les prix de l’électricité y soient parmi les plus élevés du pays.

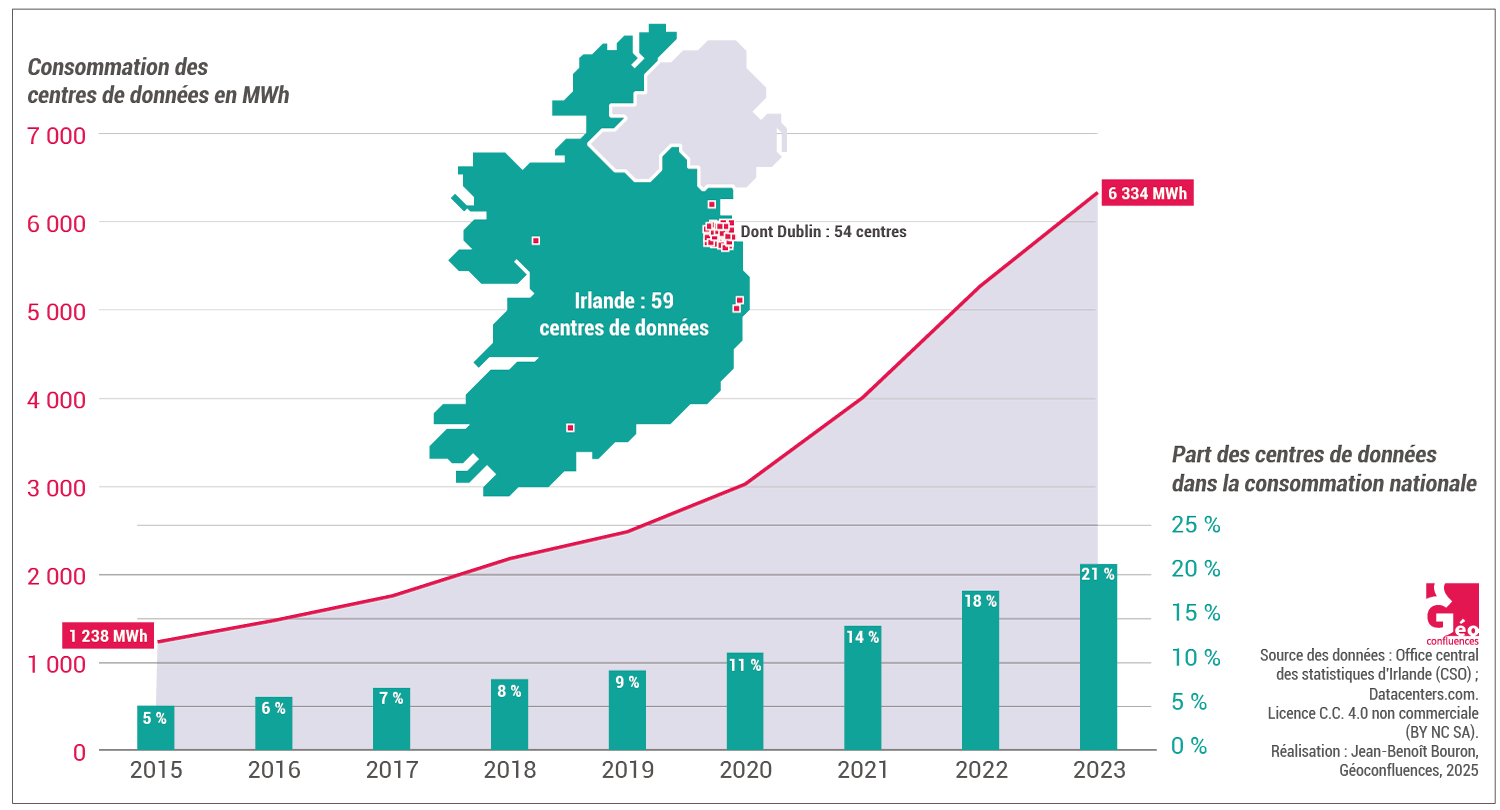

Dans ce contexte, la question énergétique devient un enjeu territorial majeur. Au Texas, le régulateur demande aux entreprises de construire eux-mêmes leur centrale électrique pour s’autoapprovisionner. En Irlande, la demande de Google de construire un troisième centre de données de 30 000 m3 sur son campus du Grange Castle Business Park dans le sud-ouest de Dublin, est rejetée par le Comté de South Dublin afin de protéger la ressource en eau et en énergie alors que les centres de données mobilisent déjà plus de 20 % de la consommation électrique nationale. En août 2024, la situation énergétique dans le nord de Taïwan est si tendue que le gouvernement interdit la construction de nouveaux centres de plus de 5 MW au nord de la ville de Taoyan : l’objectif est de transférer les nouveaux projets dans le centre et le sud de l’île afin d’équilibrer la géographie énergétique du pays.

Document 8. Irlande : l’explosion de la consommation électrique des centres de données

En Asie, Singapour, où les prix de location des terrains sont les plus élevés au monde, tout comme le prix de l’électricité, impose un moratoire aux nouveaux centres de données, puis des conditions drastiques en matière d’urbanisme, de consommation énergétique et d’engagements environnementaux. Ces choix accélèrent les ouvertures de centres en Indonésie (Jakarta) et en Malaisie (Johore, Batam), régions voisines qui proposent aussi des incitations fiscales conséquentes dans le cadre du Triangle de croissance SIJORI. La disponibilité de ressources énergétiques à coût réduit devient dans ces conditions un facteur d’attractivité des territoires, telle l’Espagne grâce aux énergies renouvelables solaire et éolienne, les pays scandinaves grâce à l’hydroélectricité ou la France grâce au nucléaire, laquelle définit en 2025 les centres de données comme « projet d'intérêt national majeur ».

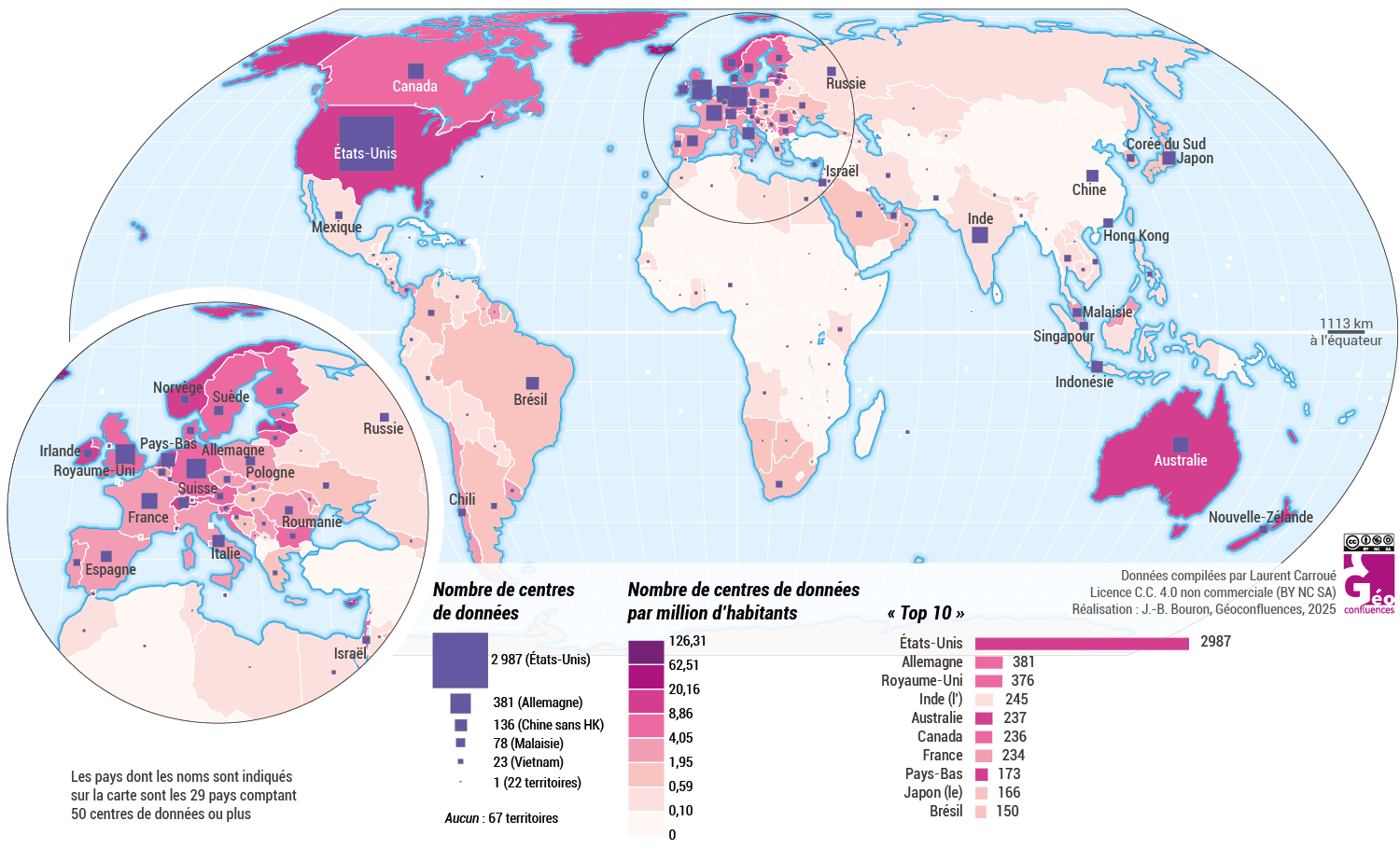

3.2. Une organisation spatiale polarisée

À l’échelle mondiale se met en place un duopôle sino-étasunien. La répartition des centres de données demeure fortement polarisée, un processus qui se renforce avec les exigences techniques de l’IA : 80 % sont situés dans seulement 21 pays. Les États-Unis dominent le monde avec 38 % des sites, mais surtout plus de 60 % de la puissance mondiale de stockage. Viennent ensuite une vingtaine d’États qui regroupent 42 % des sites ; on retrouve sans surprise les pays hautement développés (Allemagne, Royaume-Uni, Canada, France...) et les grandes puissances émergentes (Chine, Inde, Brésil, Russie, Indonésie, Malaisie...). Une place particulière doit être réservée à la Chine, qui s’avère le grand concurrent des États-Unis par la puissance installée autant que par ses firmes transnationales innovantes ; on peut donc bien parler d’un duopôle, tant l’Union européenne est qualitativement marginalisée et dominée. Pour autant, seuls les marchés chinois et pour partie asiatiques, avec NTT (Nippon Telegraph and Telephone) et Fujitsu au Japon, échappent au quasi-monopole étasunien.

Document 9. La domination mondiale des marchés des centres de données par les GAFAM

|

Rang |

Monde |

États-Unis |

Chine |

Reste de l’Asie |

Europe |

Reste du monde |

|

1 |

Amazon |

Amazon |

Alibaba |

Amazon |

Amazon |

Amazon |

|

2 |

Microsoft |

Microsoft |

Tencent |

Microsoft |

Microsoft |

Microsoft |

|

3 |

|

|

China Telecom |

|

|

|

|

4 |

Alibaba |

Oracle |

Huawei |

NTT |

Oracle |

Salesforce |

|

5 |

Oracle |

Salesforce |

China Unicom |

Alibaba |

Salesforce |

Oracle |

|

6 |

Salesforce |

IBM |

China Mobile |

Fujitsu |

IBM |

IBM |

En gras : entreprise étatsunienne. En italique : non étatsunienne. Source : Synergy Research group, 2024.

Dans cette géographie, les grandes métropoles mondiales viennent largement en tête en polarisant la majeure partie des centres de données, et surtout des puissances de stockage, comme Pékin et Shanghai en Chine, Washington/Virginie, San Francisco ou la Silicon Valley aux États-Unis, Tokyo au Japon, le système Londres/Francfort/Paris en Europe occidentale. Comme toutes les grandes innovations majeures, l’essor des centres de données et de l’IA renvoie au total largement à la géographie du développement, de la richesse et des inégalités d’un côté (Bouron et al., 2024) et aux rapports de forces technologiques, géoéconomiques et géopolitiques organisant la mondialisation de l’autre (Carroué, 2025).

Document 10. Répartition mondiale des centres de données : un système extrêmement hiérarchisé

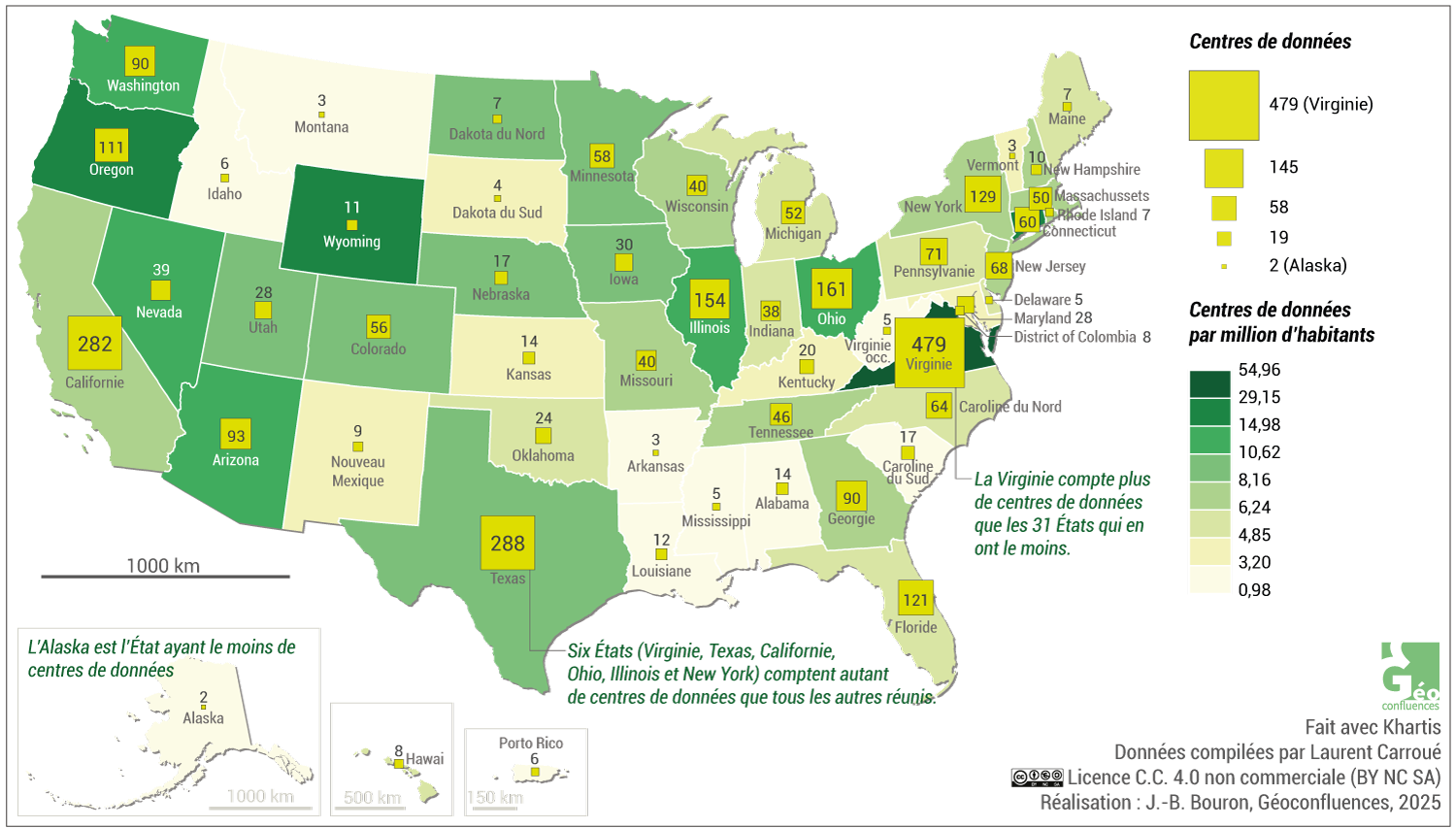

Aux États-Unis, cinq États — Virginie, Texas, Californie, Floride et New York — polarisent plus de 40 % des centres de données et des emplois. En particulier, la « Data Center Alley » de la Virginie est le premier cluster mondial et national, car desservant l’aire métropolitaine de Washington et sa zone d’influence (sièges du Dept. of Homeland Security, du Pentagone, du FBI, de la NSA, de la NGA...). On retrouve la même logique de nette polarisation à l’intérieur des autres États fédérés : en Californie trois comtés regroupent 60 % des emplois (San Francisco, Los Angeles and Santa Clara – Silicon Valley) et au Texas les trois métropoles de Dallas, Austin et San Antonio 75 % (Foote, 2025). Ces dernières années, la dynamique se diffuse au Nord-Ouest avec Portland et Seattle, où se trouvent les sièges de Microsoft et Amazon AWS, aux Grands Lacs (Ohio, Chicago...) et aux Rocheuses (Phoenix, Denver, Las Vegas, Salt Lake City).

Document 11a. Centres de données aux États-Unis, en nombre absolu et rapportés à la population

Document 11b. Géants de la tech, centres de données et semiconducteurs dans la Silicon Valley

![]()

Obtenir l'image satellite vierge (Pleiades CNES Airbus), en haute définition, cliquez ici (usage pédagogique en classe uniquement).

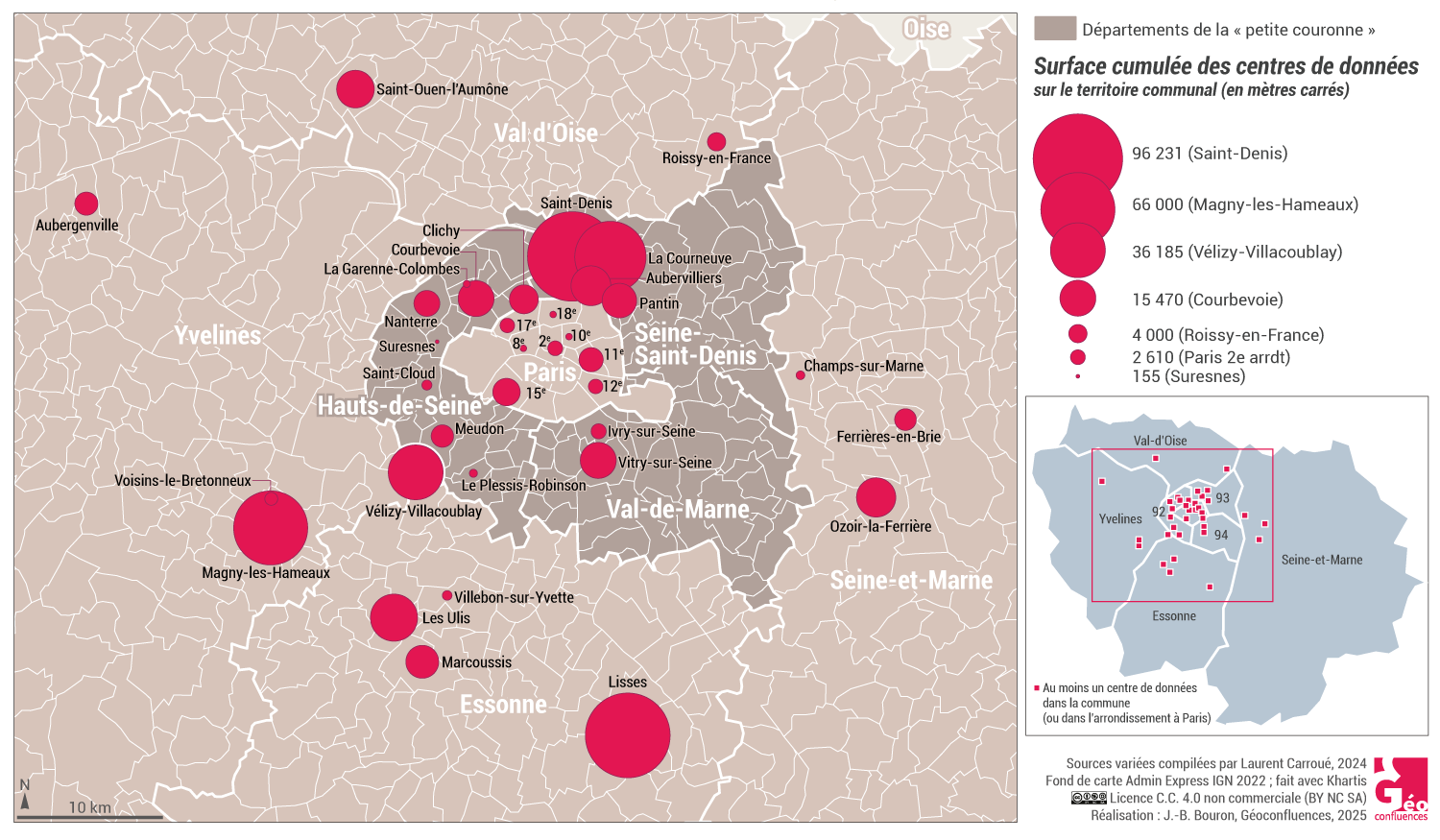

En Europe, la géographie des centres est tout aussi polarisée, en particulier sur les quatre principaux marchés du FLAP – Francfort-Londres-Amsterdam-Paris. En France, la hiérarchie métropolitaine est particulièrement marquée puisque l’Île-de-France regroupe 80 % des centres de données (Diguet, 2023). Si historiquement, la Seine Saint-Denis, en particulier la Plaine Saint-Denis, joue un rôle majeur dans l’accueil de ces entrepôts, on assiste à une diffusion croissante des nouveaux centres, souvent de grand taille, en grande couronne où se multiplient les projets (Data4 sur la friche Nokia de Nozay, Telehouse sur la friche EADS de Magny-les-Hameaux, Centre de surveillance du système GPS européen Galliléo est au Camps des Loges à St Germain en Laye...).

Document 12. Les centres de données en Île-de-France : polarisés par Paris

Document 13. La Plaine St-Denis : les atouts pour attirer les centres de données

Cette image couvre l’espace de la Plaine Saint-Denis qui s’étend entre le faisceau de voies ferrées à l’ouest, le canal Saint-Denis à l’est et le boulevard périphérique au sud. Ce vaste espace mixte industrie-habitat né d’un faubourg industriel, caractéristique de la première couronne parisienne, s’étend sur les communes de Saint-Ouen, Saint-Denis et Aubervilliers. Il connaît à partir des années 1970 un vaste processus de désindustrialisation et de reconversion fonctionnelle (commerce de gros, entrepôts...) qui y multiplie les friches industrielles. Cet espace proche de Paris, bien desservi en transports et au prix fonciers très abordables, connaît une profonde mutation urbaine et socio-économique à partir des années 1995, symbolisée par la construction du Stade de France (1995/1997) sur la ZAC du Cornillon desservi par la nouvelle gare RER de La Plaine (au nord sur l’image). Ouvert en 2019, le nouveau campus universitaire Condorcet symbolise au centre de l’image cette métamorphose. C’est dans ce contexte que la Plaine Saint-Denis devient un pôle majeur de centres de données en Île-de-France et en France, avec en particulier les implantations des groupes étasuniens Digital Realty et Equinix qui s’installent selon les occasions foncières locales. La fonction d’entrepôt de cet espace demeure, mais change de nature avec la numérisation. Les entreprises y trouvent notamment : un foncier urbain important et à prix accessible du fait de l’importance des friches industrielles ; une très bonne desserte électrique liée à la puissance des infrastructures de réseaux desservant les anciennes activités industrielles ; un bon réseau de fibres optiques pour les télécommunications.

3.3. Des enjeux géopolitiques : autonomie et souveraineté face à l’hégémon étasunien

Malgré la montée de la Chine, réelle mais encore limitée, symbolisée par le succès de DeepSeek en IA, les États-Unis déploient un hégémon impérial mondial dans la révolution numérique et l’IA. Il repose d’un côté sur une infrastructure matérielle exceptionnelle (nombre de sites, puissance de stockage et de calcul avec 21 millions de serveurs en 2021, 37 millions prévus en 2028, composants informatiques...), de l’autre sur la qualité des services fournis par les GAFAM. Jamais historiquement une poignée de firmes n’a acquis en si peu de temps une aussi grande puissance technologique, économique et financière et disposé d’une aussi grande capacité d’influence et de remodelage des rapports politiques, culturels et sociétaux influençant directement la vie quotidienne de milliards de citoyens.

Les liens de dépendance, d’influence et de domination tissés avec le reste du monde sont écrasants. Ainsi, 80 % des dépenses réalisées en Europe – un marché de 330 milliards d’euros par an (Cigref, 2025) – partent aux États-Unis, du fait en particulier du rôle incontournable d’AWS-Amazon (30 %), Microsoft Azure (21 %) et Google Cloud (14 %). 70 % des données numériques françaises sont hébergées outre-Atlantique. Dans ce contexte, l’extraterritorialité du droit étasunien constitue un levier d’affirmation de puissance exceptionnel.

Encadré 11. L’extraterritorialité du droit étasunien : un levier de projection de puissance

Ces dernières décennies, Washington s’est doté d’un arsenal juridique facilitant l’intrusion des services de police, de justice ou du renseignement dans tout le système numérique mondial (courriers électroniques, textos, métadonnées, serveurs...) au nom d’une conception extensive et impériale de leur sécurité nationale, de plus en plus étendues aux enjeux géoéconomiques et technologiques : Foreign Intelligence Surveillance Act (FISA) de 1978, USA PATRIOT Act de 2001, CLOUD Act ou Clarifying Lawful Overseas Use of Data Act de 2018, FISA version 2024... En particulier, via la règle dite de « facilitation » ou du « lien de rattachement », ce droit peut s’appliquer à l’ensemble du globe ; il est qualifié d’extraterritorial même si les acteurs – États, firmes, personnes – n’ont aucun lien territorial direct avec les États-Unis. Il suffit d’un simple contact, même ténu ou bref, comme utiliser ou transiter par un centre de données ou un serveur, qu’il soit situé aux États-Unis ou à l’étranger, s’il est propriété d’une firme étatsunienne..., pour que les GAFAM soient tenues de répondre aux réquisitions des agences gouvernementales étatsuniennes.

La question de la localisation géographique du stockage des données numériques et de la nationalité de la firme mobilisée est donc de plus en plus cruciale en matière de sécurité et de souveraineté. C’est une question de rapports de forces : en 2021, Apple est contraint par Pékin de rapatrier les données et les clés de déchiffrement de ses clients chinois d’iCloud – stockant photos, vidéos, fichiers, courriels... – dans un nouveau centre de données situé à Guiyang (Guizhou) et opéré par une société appartenant au gouvernement. Plusieurs États imposent dorénavant la localisation des données publiques ou gouvernementales sur leur territoire national (Suisse, Allemagne, Lituanie, Indonésie...). La souveraineté numérique des États et la mise hors d’atteinte des États-Unis des données sont donc devenues une exigence stratégique. Mais malgré quelques efforts récents stimulés par les stratégies très agressives de l’administration Trump, l’Union européenne et la France demeurent encore bien en retrait des besoins de création d’un système réellement souverain.

Encadré 12. Le Projet OpenEuroLLM : la souveraineté numérique de l’Europe en question

Lancé dans l’Union européenne en février 2025 et ayant son siège statutaire en France à Villers-Cotterêts, symbole historique de la souveraineté linguistique, le projet OpenEuroLLM s’inscrit dans l’initiative communautaire ALT-EDIC 4UE - Alliance for Language Technologies for the European Union de juillet 2024. Regroupant une vingtaine d’institutions de recherche, d’entreprises et de centres de calcul européens et doté d’un budget de 37 millions d’euros, il vise à renforcer la compétitivité européenne dans les technologies critiques en matière d’IA en développant selon un modèle coopératif un ensemble de modèles linguistiques libres couvrant toutes les langues européennes. À cette fin, les modèles de langage, les logiciels et les ensembles de données doivent en être « libres » et donc accessibles à tous en open source. De nombreux pays y participent : France, Finlande, Pays-Bas, Tchéquie, Allemagne, Espagne et Italie.

Conclusion

La révolution numérique, et l’essor foudroyant de l’intelligence artificielle qui constitue une nouvelle innovation de rupture dont on peine encore à saisir toute l’importance, aboutissent à une explosion de la production de données numériques. Le stockage, la protection et le traitement de cette masse de données aboutit à la création d’entrepôts spécialisés : les centres de données, ou data centers. Insérées dans les réseaux de transport (câbles, routeurs...) et de gestion de l’internet, toutes ces infrastructures névralgiques finissent par faire système : c’est le cyberespace.

Ces coffres-forts numériques présentent de fortes contraintes de localisation et nécessitent des investissements financiers considérables : sécurité, alimentation électrique massive de systèmes particulièrement énergétivores et polluants, branchement sur des réseaux de fibre optique assurant des temps de latence les plus faibles possibles entre fournisseurs et clients... Aux échelles locales ou régionales, elles aboutissent à la création de pôles fonctionnels spécialisés, ou clusters. A l’échelle mondiale, ce système est polarisé à 80 % par une vingtaine d’États et un nombre fort restreint de grandes aires métropolitaines en haut de la hiérarchie urbaine mondiale.

Les enjeux d’innovation, de compétitivité et de souveraineté entre États et entre firmes sont tels que le secteur devient un enjeu majeur des rivalités géopolitiques et géoéconomiques organisant la mondialisation. Le numérique, en particulier les centres de données et l’IA, demeure le secteur dans lequel les États-Unis disposent encore d’un hégémon impérial mondial. Il repose d’un côté sur une infrastructure matérielle exceptionnelle, de l’autre sur la qualité des services fournis par les GAFAM. Face à eux, seule la Chine dispose des leviers permettant de déployer une offre autonome concurrente, comme en témoigne ces dernières années la position de plus en plus agressive de Washington contre Pékin. Alors que l’Union européenne reste éclatée, marginale et dominée.

Derrière des débats parfois très techniques et les stratégies de localisation dans l’espace géographique des centres de données se cachent d’immenses jeux de pouvoirs et enjeux de puissance et de souveraineté, donc de liberté et de démocratie. En particulier géopolitiques et civilisationnels, alors que rarement dans l’histoire une poignée de firmes, en l’occurrence les GAFAM, n’a disposé d’une aussi grande capacité d’influence et de remodelage des rapports politiques, culturels et sociétaux influençant directement la vie quotidienne de milliards de citoyens.

Bibliographie

Références citées

- Agence Internationale de l’Énergie (2025), Electricity 2025. Analysis and forecast to 2027, Washington, 199 p.

- Bouron J-B, Carroué L. et Mathian H. (2024), « Représenter et découper le monde : dépasser la limite Nord-Sud pour penser les inégalités de richesse et le développement », Géoconfluences, décembre 2022.

- Carroué L. (2025) : Géographie de la mondialisation. Tensions, crises et basculement du monde, Autrement, 3e édition, Paris, 2025.

- Cigref et Asterès (2025), La dépendance technologique aux softwares et au cloud services américains : une estimation des conséquences économiques en Europe, avril 2025, Paris.

- Diguet Cécile, Gawlik Maximilian et Laruelle Nicolas (2023), Le développement des data centers en Ile-de-France, Éléments pour une stratégie régionale et territoriale, Institut Paris Région, Paris, 95 p.

- Foote Andrew et Wilkie-Rogers Caelan (2025), “Employment in Data Centers Increased by More Than 60% From 2016 to 2023 But Growth Was Uneven Across the United States”, America Counts Stories, United Census Bureau, January 6, 2025.

- Gartner (2025,) « Gartner Forecasts Worldwide IT Spending to Grow 9.8% in 2025”, Gartner, Stamford, January 21, 2025.

- Shehabi A. et al. (2024), United States Data Center Energy Usage Report. Lawrence Berkeley National Laboratory, Berkeley, California, pour l’US Dept. of Energy/EERE.

Pour aller plus loin

- Site des données sur les data centers : https://www.datacentermap.com/

- Commission de l’intelligence artificielle, : « IA : notre ambition pour la France », Rapport de mars 2024 à la Présidence de la République française.

- Laurent Carroué, 2025, « États-Unis - Virginie. La Data Center Alley : le 1er pôle mondial de centres de données au cœur du cyberespace et de l’hégémon étatsunien », Géoimage, CNES, novembre 2025.

- Carlo d'Asaro Biondo et Francis Morel (2025), L'Humanité face à l'IA. Le combat du siècle, Editions Calmann Lévy, Paris, 316 p.

- Giuliano da Empoli (2024), Les ingénieurs du Chaos, J.C. Lattès, Paris, 224 p.

- Rémy Demichelis (2024), Intelligence artificielle, ses biais et les notres, Editions du Faubourg, Paris, 190 p.

- Limonier Kévin, Cattaruzza Amaël (2022), « Terrains numériques : la datasphère, nouveau(x) terrain(s) exploratoire(s) de la géographie ? », Bulletin de l’Association de Géographes Français, 99–2, 2022.

- Béatrice Giblin et Kévin Limonier (dir.) (2022) : « OSINT. Enquêtes et terrains numériques », Revue Hérodote, n° 186/2022.

Pour compléter avec Géoconfluences

- Anne-Lise Boyer et Lætitia Balaresque, « Les États-Unis dans le changement climatique », Géoconfluences, septembre 2024.

- Laurent Carroué, « La Silicon Valley, un territoire productif au cœur de l’innovation mondiale et un levier de la puissance étatsunienne », Géoconfluences, mai 2019.

- Laurent Carroué, « La révolution du gaz et du pétrole de schiste aux États-Unis : enjeux technologiques, territoriaux et géostratégiques », Géoconfluences, mai 2022.

- Laurent Carroué, « Le boom des hydrocarbures non conventionnels dans le Bassin permien (Texas et Nouveau-Mexique, États-Unis) », Géoconfluences, juin 2022.

Mots-clés

Retrouvez les mots-clés de cet article dans le glossaire : câbles sous-marins | centre de données | cluster | cyberespace | financiarisation | gaz à effet de serre | géants du numérique ou GAFAM | souveraineté.

Laurent CARROUÉ

Inspecteur général de l’éducation, du sport et de la recherche, directeur de recherche à l’IFG – université Paris VIII

Cartographie, édition et mise en web : Jean-Benoît Bouron

Pour citer cet article :

Laurent Carroué, « L’essor des centres de données : intelligence artificielle, cyberespace, pouvoir et territoire », Géoconfluences, juillet 2025.

https://geoconfluences.ens-lyon.fr/informations-scientifiques/dossiers-thematiques/geographie-critique-des-ressources/articles/centres-de-donnees-intelligence-artificielle-cyberespace-pouvoir-et-territoire

Mode zen

Mode zen